Khám Phá Các Mô Hình Ngôn Ngữ Lớn (LLMs): Tương Lai Của Lập Trình và Công Nghệ

1. Giới thiệu

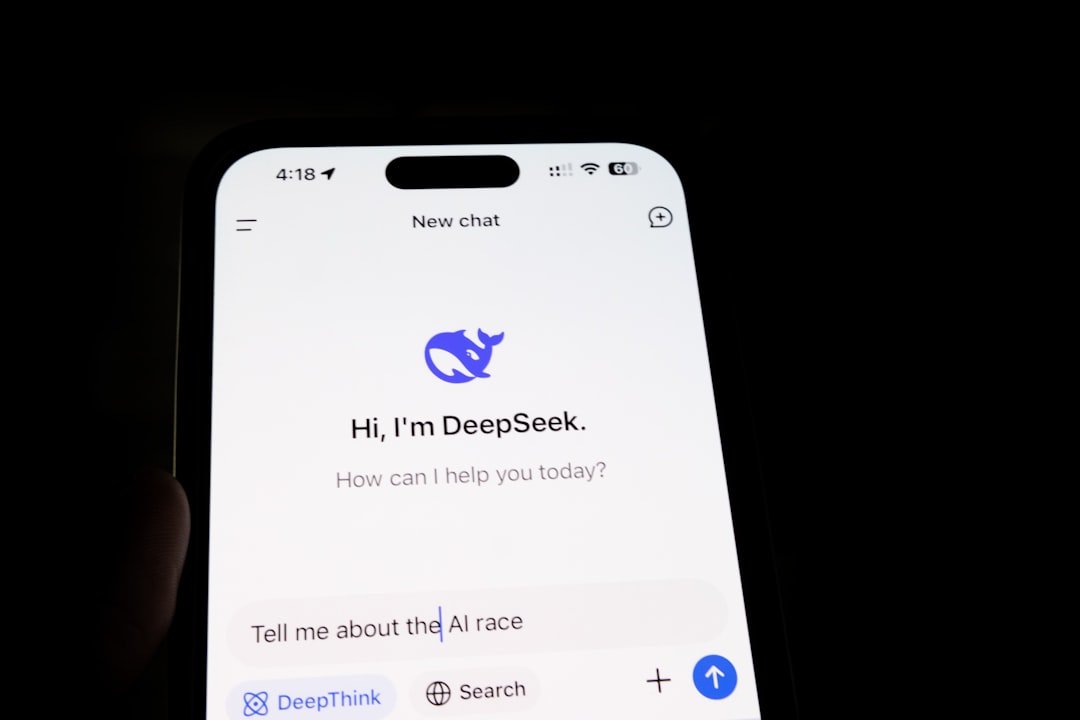

Trong thập kỷ qua, Mô Hình Ngôn Ngữ Lớn (LLMs) đã trở thành một phần không thể thiếu trong lĩnh vực trí tuệ nhân tạo (AI) và học máy. Chúng được phát triển từ những năm 2010 với sự tiến bộ vượt bậc trong các thuật toán học sâu (deep learning) và lượng dữ liệu khổng lồ trên Internet. LLMs như GPT-3, BERT và các phiên bản không ngừng được cải thiện khác đã mở ra những khả năng mới trong xử lý ngôn ngữ tự nhiên (NLP), từ việc ghi nhận và hiểu ngữ cảnh cho đến việc tạo ra nội dung tự động.

Trong bài viết này, chúng ta sẽ đi sâu vào các khía cạnh cốt lõi của LLMs, khám phá cách thức hoạt động, các kỹ thuật nâng cao, cùng với những ứng dụng thực tế và xu hướng tương lai. Tính quan trọng của LLMs trong ngành công nghiệp phần mềm là không thể phủ nhận, với sự áp dụng mạnh mẽ trong các sản phẩm, dịch vụ và quy trình làm việc.

2. Kiến thức nền tảng

2.1. Các khái niệm cốt lõi và nguyên lý hoạt động

LLMs hoạt động dựa trên các nguyên tắc học sâu, đa phần sử dụng kiến trúc Transformer, cho phép mô hình hiểu và tạo ra ngôn ngữ tự nhiên một cách tự động. Mô hình được huấn luyện trên lượng lớn dữ liệu văn bản để dự đoán từ tiếp theo trong câu, từ đó học được cấu trúc, ngữ nghĩa và ngữ cảnh của ngôn ngữ.

2.2. Kiến trúc và mô hình thiết kế phổ biến

Kiến trúc Transformer ra đời vào năm 2017 và đã chiếm lĩnh lĩnh vực NLP. Với hai thành phần chính là Encoder và Decoder, mô hình này cho phép xử lý đồng thời các từ trong câu thay vì tuần tự như các mô hình trước đó.

2.3. So sánh với các công nghệ/kỹ thuật tương tự

- RNN (Recurrent Neural Network): Được sử dụng trước khi Transformer, RNN xử lý dữ liệu theo tuần tự, nhưng gặp khó khăn trong việc ghi nhớ các thông tin xa trong chuỗi.

- CNN (Convolutional Neural Network): Thường được áp dụng trong xử lý hình ảnh, CNN cũng đã được thử nghiệm trên dữ liệu ngôn ngữ, nhưng không hiệu quả bằng Transformer.

3. Các kỹ thuật nâng cao

3.1. Fine-Tuning LLMs

```python from transformers import GPT2LMHeadModel, GPT2Tokenizer

Tải mô hình và tokenizer

model_name = 'gpt2'

model = GPT2LMHeadModel.from_pretrained(model_name)

tokenizer = GPT2Tokenizer.from_pretrained(model_name)

Ghi chú: Chuẩn bị dữ liệu huấn luyện và cấu hình khác ở đây

inputs = tokenizer("Hãy viết một đoạn văn về Trái Đất.", return_tensors='pt') outputs = model(**inputs)

Kết quả là đầu ra phía trước của mô hình

predictions = outputs.logits.argmax(dim=-1)

generated_text = tokenizer.decode(predictions[0])

print(generated_text)

**Giải thích**: Đoạn mã trên sử dụng thư viện `Transformers` để tải về mô hình GPT-2 và tokenizer, sau đó tạo ra văn bản dựa trên một câu đầu vào.

### 3.2. Transfer Learning

```python from transformers import pipeline

# Sử dụng pipeline cho Task Generation

generator = pipeline('text-generation', model='gpt2')

# Tạo văn bản tự động

text = generator("Trong một thế giới nơi công nghệ phát triển vượt bậc,", max_length=50, num_return_sequences=1)

print(text)

Giải thích: Kỹ thuật transfer learning cho phép người dùng tận dụng các mô hình đã được huấn luyện sẵn để thực hiện các tác vụ khác nhau một cách nhanh chóng và hiệu quả.

3.3. Few-Shot Learning

```python from transformers import GPT2Tokenizer, GPT2LMHeadModel

Tải mô hình GPT-2

tokenizer = GPT2Tokenizer.from_pretrained("gpt2")

model = GPT2LMHeadModel.from_pretrained("gpt2")

Đầu vào cho few-shot learning

prompt = "Dịch sang tiếng Việt: 'Hello, how are you?'"

Tạo văn bản

inputs = tokenizer(prompt, return_tensors='pt')

outputs = model.generate(**inputs, max_length=50)

result = tokenizer.decode(outputs[0], skip_special_tokens=True)

print(result) ``` Giải thích: Few-shot learning cho phép mô hình thực hiện các tác vụ mới chỉ với một vài ví dụ, thể hiện khả năng thích ứng của LLMs.

3.4. Mô Hình Sinh Văn Bản

```python from transformers import T5Tokenizer, T5ForConditionalGeneration

Tải mô hình và tokenizer

model = T5ForConditionalGeneration.from_pretrained('t5-base')

tokenizer = T5Tokenizer.from_pretrained('t5-base')

Đầu vào

input_text = "summarize: Cuộc cách mạng công nghiệp 4.0 đem lại lợi ích to lớn."

Tạo đầu vào cho mô hình

input_ids = tokenizer.encode(input_text, return_tensors="pt")

Tạo đầu ra

summary_ids = model.generate(input_ids, max_length=50)

Giải mã văn bản

summary = tokenizer.decode(summary_ids[0], skip_special_tokens=True)

print(summary)

**Giải thích**: Mô hình T5 được thiết kế để xử lý nhiều loại tác vụ khác nhau như tóm tắt, dịch và hỏi đáp chỉ với cùng một kiến trúc.

## 4. Tối ưu hóa và Thực tiễn tốt nhất

### 4.1. Các chiến lược tối ưu hóa hiệu suất

- **Sử dụng GPU**: Để tăng tốc độ huấn luyện và phát triển ứng dụng, GPU là lựa chọn tối ưu để xử lý các mô hình lớn.

- **Batch Normalization**: Kỹ thuật này giúp cải thiện khả năng hội tụ của mô hình và giảm thời gian huấn luyện.

### 4.2. Các mẫu thiết kế và kiến trúc được khuyến nghị

- **Kiến trúc mô-đun**: Sử dụng các mô-đun riêng lẻ cho từng phần của ứng dụng để dễ dàng bảo trì và phát triển.

- **Chia tách nhiệm vụ**: Tạo ra các mô hình hoặc module riêng cho từng tác vụ cụ thể để tăng cường hiệu suất.

### 4.3. Xử lý các vấn đề phổ biến

- **Overfitting**: Sử dụng các kỹ thuật như dropout và early stopping để ngăn chặn hiện tượng này.

- **Thiếu dữ liệu**: Tận dụng transfer learning để khai thác các mô hình đã được huấn luyện trên tập dữ liệu lớn.

## 5. Ứng dụng thực tế

### 5.1. Ví dụ ứng dụng thực tế: Chatbot tự động

```python from transformers import pipeline

# Tạo một chatbot sử dụng mô hình T5

chatbot = pipeline('conversational', model='microsoft/DialoGPT-medium')

# Thực hiện cuộc hội thoại

response = chatbot("Xin chào, bạn có khỏe không?")

print(response)

Giải thích: Đoạn mã trên sử dụng mô hình DialoGPT để tạo một chatbot có khả năng trò chuyện tự nhiên với người dùng.

5.2. Giải thích từng bước triển khai

- Tải mô hình từ thư viện

transformers. - Sử dụng phương thức

pipelineđể xây dựng chatbot. 3. Sử dụng phương thức gọi với các câu hỏi và nhận phản hồi.

5.3. Kết quả và phân tích hiệu suất

Chatbot có khả năng phản hồi tự nhiên và linh hoạt, giúp cải thiện trải nghiệm người dùng trong các dịch vụ khách hàng hoặc ứng dụng tương tác.

6. Xu hướng và Tương lai

6.1. Các xu hướng mới nhất

- Mô hình lớn hơn: Sự ra đời của các mô hình lớn hơn và phức tạp hơn (như GPT-4) làm tăng khả năng ngữ nghĩa và hiểu biết của máy.

- Thí nghiệm đa phương thức: Kết hợp văn bản, hình ảnh và âm thanh trong một mô hình duy nhất.

6.2. Các công nghệ/kỹ thuật đang nổi lên

- Mô hình Optimized for Edge: Các mô hình nhỏ gọn hơn được tối ưu cho các thiết bị không có năng lượng lớn như smartphone hoặc IoT.

- Mô hình Adaptation: Các phương pháp điều chỉnh mô hình nhẹ hơn để phù hợp với ngữ cảnh và đặc điểm dữ liệu của từng ứng dụng cụ thể.

6.3. Dự đoán về hướng phát triển trong tương lai

Tương lai của LLMs hứa hẹn sẽ có sự phát triển mạnh mẽ trong các lĩnh vực như giáo dục, chăm sóc sức khỏe và tự động hóa. Hiệu quả trong việc tạo ra nội dung chất lượng cao và, thậm chí, khả năng quyết định tự động là những mục tiêu dài hạn đang được hướng tới.

7. Kết luận

LLMs đã định hình lại cách mà chúng ta tương tác với máy tính và các ứng dụng trong ngành công nghiệp phần mềm. Chúng không chỉ cải thiện khả năng tạo nội dung mà còn phục vụ cho nhiều tác vụ liên quan đến ngôn ngữ khác nhau.

Lời khuyên cho người đọc

Để tận dụng tối đa LLMs, hãy tìm hiểu sâu về kiến trúc Transformer, nghiên cứu các kỹ thuật tối ưu hóa và thực hành trên các ứng dụng thực tế để nâng cao kỹ năng của mình.

Tài nguyên học tập bổ sung

Hy vọng bài viết này đã giúp bạn hiểu rõ hơn về LLMs và cách thức áp dụng chúng trong các dự án thực tế. Hãy khám phá và áp dụng những kiến thức này vào công việc của bạn!

Câu hỏi thường gặp

1. Làm thế nào để bắt đầu với chủ đề này?

Để bắt đầu, bạn nên tìm hiểu các khái niệm cơ bản và thực hành với các ví dụ đơn giản.

2. Nên học tài liệu nào để tìm hiểu thêm?

Có nhiều tài liệu tốt về chủ đề này, bao gồm sách, khóa học trực tuyến và tài liệu từ các nhà phát triển chính thức.

3. Làm sao để áp dụng chủ đề này vào công việc thực tế?

Bạn có thể áp dụng bằng cách bắt đầu với các dự án nhỏ, sau đó mở rộng kiến thức và kỹ năng của mình thông qua thực hành.